"你无法在摘要上进行模式匹配,阅读他人对知识的压缩会创造知识的幻觉;二手洞见不是洞见,模式识别需要高质量的数据。"

这句话讲得很好,学习一门新知识,必须系统的看一些经典的书籍。

关于机器学习(或深度学习)的书籍也看了很多,推荐几本书以及阅读顺序(书籍封面见文末)。

1、《Deep Learning with Python》(《Python深度学习》 国内有该书第二版的正式中文版),深入浅出的介绍了机器学习的内容,作为宏观的机器学习(深度学习)的入门级书籍,条理很清晰,让你知其然;

2、《Hands-On Large Language Models》,一本很新的书,2024年出版的,没有正式的中文版(不过为了阅读方面,自己倒是翻译了),这本书的特色是图文并茂,人是视觉动物,一张图胜过千言万语,这本书把大语言模型的基础概念、基础原理简述得很清楚,在技术的深度上也把握得很好,不过太过技术化。这本书在阅读过《Deep Learning with Python》的基础上再看更好,因为大语言模型的底层技术架构是深度学习,需要对神经网络的一些概念有基础。

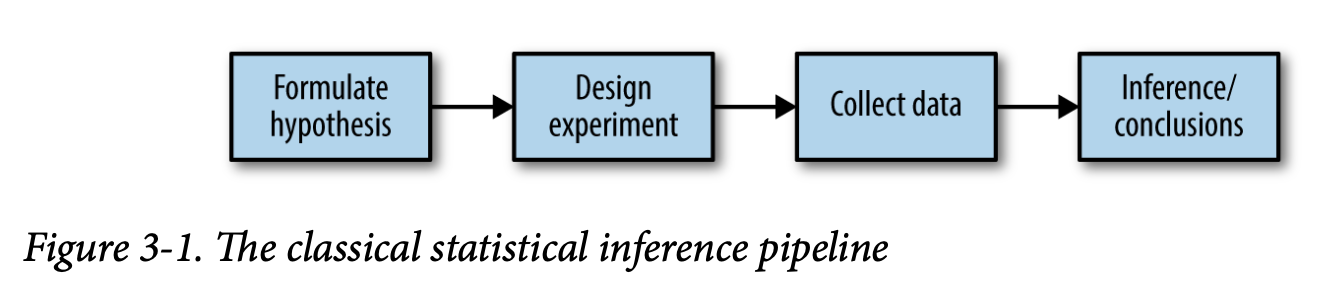

3、《Practical Statistics For Data Scientists》(数据科学家的实用统计,国内有第一版的正式中文版,不过,为了方便阅读,自己翻译了该书的第二版),这本书从数据科学家所需要的统计视角来展开,介于基础数学和计算机之间,主要从统计学的角度去阐述相关的主题和概念,关键的混淆点也能指出。并且结合Python、R,列举了很多的案例,是一本很好的统计学基础书籍。这本书从数据科学家而不是数学家的角度出发,所以摒弃了很多数学公式和细节。

4、《MATHEMATICS FOR MACHINE LEARNING》 (《机器学习的数学基础》,网上有该书Part I部分的翻译,为了方便阅读,自己翻译了Part II部分),这本书详细的把机器学习相关的数学知识和概念系统的介绍了一次,让你知其所以然。这本书系统化的介绍了与机器学习有关的数学概念,整体性、系统性非常好。概念之间的联系非常清晰。 关于机器学习相关的数学书籍,可以参考“打好数据科学和机器学习的基础——6本书带你学数学” https://www.dataapplab.com/6-best-books-to-learn-mathematics-for-data-science-machine-learning/

以上几本书是从原理的角度出发,从AI深度学习原理、深度学习的数学基础、统计学基础等方面进行讲解,那以下这本书就是AI的实际应用,智能体(agent)的讲解。

5、《Agentic Design Patterns: A Hands-On Guide to Building Intelligent Systems》(Antonio Gulli 所著)

该书是一部全面的技术指南,涵盖了现代人工智能系统中智能体 (Agent) 设计的核心概念和实践方法。

这本书还有一个特点,就是这本书的英文版先是在google doc中公开的,在英文版正式付印前,github上的中文翻译版已经完成了。这就是AI的力量,通过AI翻译,让中文读者能第一时间看到英文版的资料(当然是符合相关的开源协议,也所谓的知识民主化)