《统计学习基础》 (2/6)

读书笔记之二:第3章-第4章

第三章:线性回归方法; 第四章:线性分类方法。

第三章 线性回归方法

总结:

- 对于任意一个有限维的矩阵(实数或复数矩阵),它的行秩 = 列秩。这个值也被称为矩阵的秩(rank);

- 标准化因数或者 Z-分数,\(z_j\) 分布为 \(t_{N-p-1}\)(自由度为 \(N-p-1\) 的 \(t\) 分布);

- \(t\) 分布和标准正态分布在尾概率之间的差异随着样本规模增大可以忽略;

- \(F\) 统计量衡量了在大模型中每个增加的系数对残差平方和的改变;

- 当 \(N\) 足够大时,\(F_{p_1-p_0,N-p_1-1}\) 近似 \(\chi^2_{p_1-p_0}\).

3.1 Guass-Markov 定理

统计学中一个很有名的结论称参数 \(\beta\) 的最小二乘估计在所有的线性无偏估计中有最小的方差。

考虑 \(\theta\) 的估计值 \(\tilde{\theta}\) 的均方误差 \[ \begin{align} \text MSE(\tilde{\theta})&=\text E(\tilde{\theta}-\theta)^2\notag\\ &=\text Var(\tilde{\theta})+[\text E(\tilde{\theta})-\theta]^2\tag{3.20} \end{align} \] 第一项为方差,第二项为平方偏差.Gauss-Markov 定理表明最小二乘估计在所有无偏线性估计中有最小的均方误差。

然而,或许存在有较小均方误差的有偏估计.这样的估计用小的偏差来换取方差大幅度的降低.实际中也会经常使用有偏估计.

任何收缩或者将最小二乘的一些参数设为 0 的方法都可能导致有偏估计.我们将在这章的后半部分讨论许多例子,包括 变量子集选择 和 岭回归.从一个更加实际的观点来看,许多模型是对事实的曲解,因此是有偏的;

挑选一个合适的模型意味着要在偏差和方差之间创造某种良好的平衡。

3.2 从简单单变量回归到多重回归

内积表示是线性回归模型一般化到不同度量空间(包括概率空间)建议的方式。

若模型为: \[ y = \beta_0 + \beta_1 x_1 + \beta_2 x_2 + \cdots + \beta_p x_p + \varepsilon \]

则: \[ \hat{\beta}_0 = \bar{y} - \sum_{j=1}^{p} \hat{\beta}_j \bar{x}_j \]

依然体现了:截距项用于保证模型在均值点的预测值等于 \(\bar{y}\)。 截距和样本均值有严格的线性关系。

在带截距的线性回归中,回归线总通过样本均值点 \((\bar{x}, \bar{y})\),这是一个非常重要的几何性质。

3.3 子集的选择

两个原因使得我们经常不满足最小二乘估计 (3.6)

- 第一个是预测的 精确性 (prediction accuracy):最小二乘估计经常有小偏差大方差.预测精确性有时可以通过收缩或者令某些系数为 0 来提高.通过这些方法我们牺牲一点偏差来降低预测值的方差,因此可能提高整个预测的精确性.

- 第二个原因是 可解释性 (interpretation):当有大量的预测变量时,我们经常去确定一个小的子集来保持最强的影响.为了得到“big picture”,我们愿意牺牲一些小的细节.

这节我们描述一些线性回归选择变量子集的方法.在后面的部分中我们讨论用于控制方差的收缩和混合的方法,以及其它降维的策略.这些都属于 模型选择 (model selection).模型选择不局限于线性模型;第 7 章将详细介绍这个主题.

子集选择意味着我们只保留变量的一个子集,并除去模型中的剩余部分。最小二乘回归用来预测保留下的输入变量的系数.这里有一系列不同的选择子集的策略:

3.3.1 最优集的选择

AIC 准则是一个受欢迎的选择

3.3.2 向前和向后逐步选择

其它传统的包中的选择基于 \(F\) 统计量,加入“显著性”的项,然后删掉“非显著性”的项.这些不再流行,因为它们没有合理考虑到多重检验的问题.

3.3.3 向前逐渐 (Forward-Stagewise) 回归

使用“一个标准误差”规则——在最小值的一个标准误差范围内我们选取最简洁的模型。

3.4 收缩的方法

通过保留一部分预测变量而丢弃剩余的变量,子集选择 (subset selection) 可得到一个可解释的、预测误差可能比全模型低的模型.然而,因为这是一个离散的过程(变量不是保留就是丢弃),所以经常表现为高方差,因此不会降低全模型的预测误差.而收缩方法 (shrinkage methods) 更加连续,因此不会受 高易变性 (high variability) 太大的影响.

3.4.1 岭回归

- 系数向零收缩(并且彼此收缩到一起);

- 通过参数的平方和来惩罚的想法也用在了神经网络,也被称作 权重衰减 (weight decay)

- 对输入按比例进行缩放时,岭回归的解不相等,因此求解公式 \(\text{3.41}\)前我们需要对输入进行标准化.另外,注意到惩罚项不包含截距 \(\beta_0\).对截距的惩罚会使得过程依赖于 \(\mathbf{Y}\) 的初始选择;

- 对输入进行中心化(每个 \(x_{ij}\) 替换为 \(x_{ij}-\bar x_j\))

- 主成分回归与岭回归非常相似:都是通过输入矩阵的主成分来操作的.岭回归对主成分系数进行了收缩,收缩更多地依赖对应特征值的大小;主成分回归丢掉 \(p-M\) 个最小的特征值分量.

- 越小的奇异值 \(d_j\) 对应 \(\mathbf{X}\) 列空间中方差越小的方向,并且岭回归在这些方向上收缩得最厉害.

图 3.9 展示了两个维度下部分数据点的主成分.如果我们考虑在这个区域(\(Y\) 轴垂直纸面)内拟合线性曲面,数据的结构形态使得确定梯度时长方向会比短方向更精确.岭回归防止在短方向上估计梯度可能存在的高方差.隐含的假设是响应变量往往在高方差的输入方向上变化.这往往是个合理的假设,因为我们所研究的预测变量随响应变量变化而变化,而不需要保持不变.

图 3.9 部分输入数据点的主成分.最大主成分是使得投影数据方差最大的方向,最小主成分是使得方差最小的方向.岭回归将 \(\mathbf{y}\) 投射到这些成分上,然后对低方差成分的系数比高方差收缩得更厉害.

3.4.2 Lasso

- 由于该约束的本质,令 \(t\) 充分小会造成一些参数恰恰等于 0.因此 lasso 完成一个温和的连续子集选择.

- 类似在变量子集选择中子集的大小,或者岭回归的惩罚参数,应该自适应地选择 \(t\) 使预测误差期望值的估计最小化.

- lasso 曲线会达到 0,然而岭回归不会.曲线是分段线性的

3.5 讨论:子集的选择,岭回归,Lasso

有约束的线性回归模型的三种方法:子集选择、岭回归和 lasso.

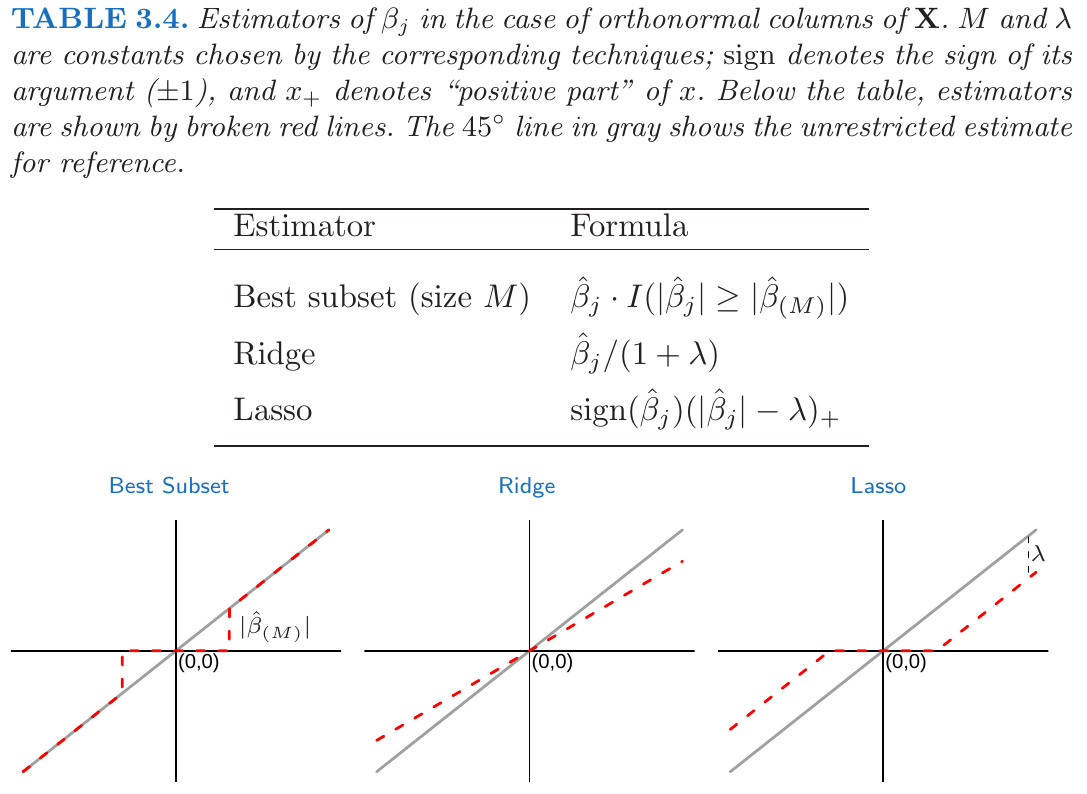

- 在正交输入矩阵的情况下,三种过程都有显式解.每种方法对最小二乘估计 \(\hat{\beta}_j\) 应用简单的变换,详见表 3.4.

- 岭回归做等比例的收缩.lasso 通过常数因子 \(\lambda\) 变换每个系数,在 0 处截去.这也称作“软阈限”,而且用在 5.9 节中基于小波光滑的内容中.最优子集选择删掉所有系数小于第 \(M\) 个大系数的变量;这是“硬阈限”的一种形式.

- lasso、岭回归和最优子集选择是有着不同先验分布的贝叶斯估计,然而,注意到它们取自后验分布的众数,即最大化后验分布.在贝叶斯估计中使用后验分布的均值更加常见.岭回归同样是后验分布的均值,但是 lasso 和最优子集选择不是.

第四章 线性分类方法

贝叶斯定理(Bayes’ Theorem)是概率论中一个非常重要的定理,用于在已知结果的情况下推断原因(也就是“后验概率”)。

贝叶斯定理告诉我们如何根据已有信息更新对某事件的信念。

对于两个事件 \(A\) 和 \(B\),只要 \(P(B) > 0\),贝叶斯定理公式如下:

\[ P(A|B) = \frac{P(B|A) \cdot P(A)}{P(B)} \]

其中:

- \(P(A)\):先验概率,事件 A 发生的原始概率;

- \(P(B|A)\):似然度,在 A 发生的条件下,观察到 B 的概率;

- \(P(B)\):边缘概率,B 发生的总概率;

- \(P(A|B)\):后验概率,在 B 发生的前提下,A 发生的概率。

全书的读书笔记(共6篇)如下:

《统计学习基础》读书笔记之一

《统计学习基础》读书笔记之二

《统计学习基础》读书笔记之三

《统计学习基础》读书笔记之四

《统计学习基础》读书笔记之五

《统计学习基础》读书笔记之六